第四章 波形信源与波形信道

第一节 波形信源的统计特性与离散化

随机波形信源:输出是时间与取值都连续的随机过程 \({x(t)}\)。每个样本函数 \(x_i(t)\) 是随机过程的一个实现。可分为:平稳过程与非平稳过程,这个在不同的课里面讲的第三遍了。

遍历性

具体是啥我这里也不细讲了,直接就用这个遍历性吧。这个也好几遍了。

遍历随机过程满足时间平均 = 统计平均(以概率1成立):

\[ \lim_{T\to\infty} \frac{1}{2T}\int_{-T}^T x(t)\,dt = E[X(t)]. \]

取样与量化

对限频随机过程取样,每个样本值是一个随机变量;

在限时 \(T\) 内、带宽 \(F\) 的情况下,可得 \(2FT\) 个取样值;

再经过量化(离散化),即可得到离散随机序列。

随机波形信源经取样 + 量化 → 连续信源 → 离散信源。

一般来说,直接就给通信系统中的信号给认为是平稳随机过程。

第二节 连续信源与波形信源的信息测度

(1) 连续信源的定义

信源输出为连续随机变量,可用概率密度函数 \(p(x)\) 描述:

\[ \int_R p(x)\,dx = 1. \]

其对应的一维、联合及条件概率密度函数分别为 \(p(x)\)、\(p(x,y)\)、\(p(y|x)\)。

(2) 连续信源的熵(差熵)

从离散熵推广而来:

\[ h(X) = -\int_R p(x)\log_2 p(x)\,dx \]

注意:

与离散熵形式相似,但概念不同;

\(h(X)\) 可为负值(如均匀分布区间 <1 时),不具有离散熵的非负性;

表示“相对不确定度”,又称相对熵。

还是给他叫做差熵比较好,因为他不具有离散信源熵的绝对性,不能代表信源的平均不确定度,不能代表连续信源输出的信息量,只能是一个相对的值,不具有非负性。

(3) 常见连续信源的差熵

均匀分布:

\[ p(x)=\frac{1}{b-a},\quad h(X)=\log_2(b-a) \]

高斯分布:

\[ p(x)=\frac{1}{\sqrt{2\pi\sigma^2}}\exp\!\left(-\frac{(x-m)^2}{2\sigma^2}\right) \]

\[ h(X)=\frac{1}{2}\log_2(2\pi e\sigma^2) \]

高斯信源熵只与方差 \(\sigma^2\) 有关,与均值 \(m\) 无关。这个和连续信号的差熵的具体含义:相对的熵向一致。

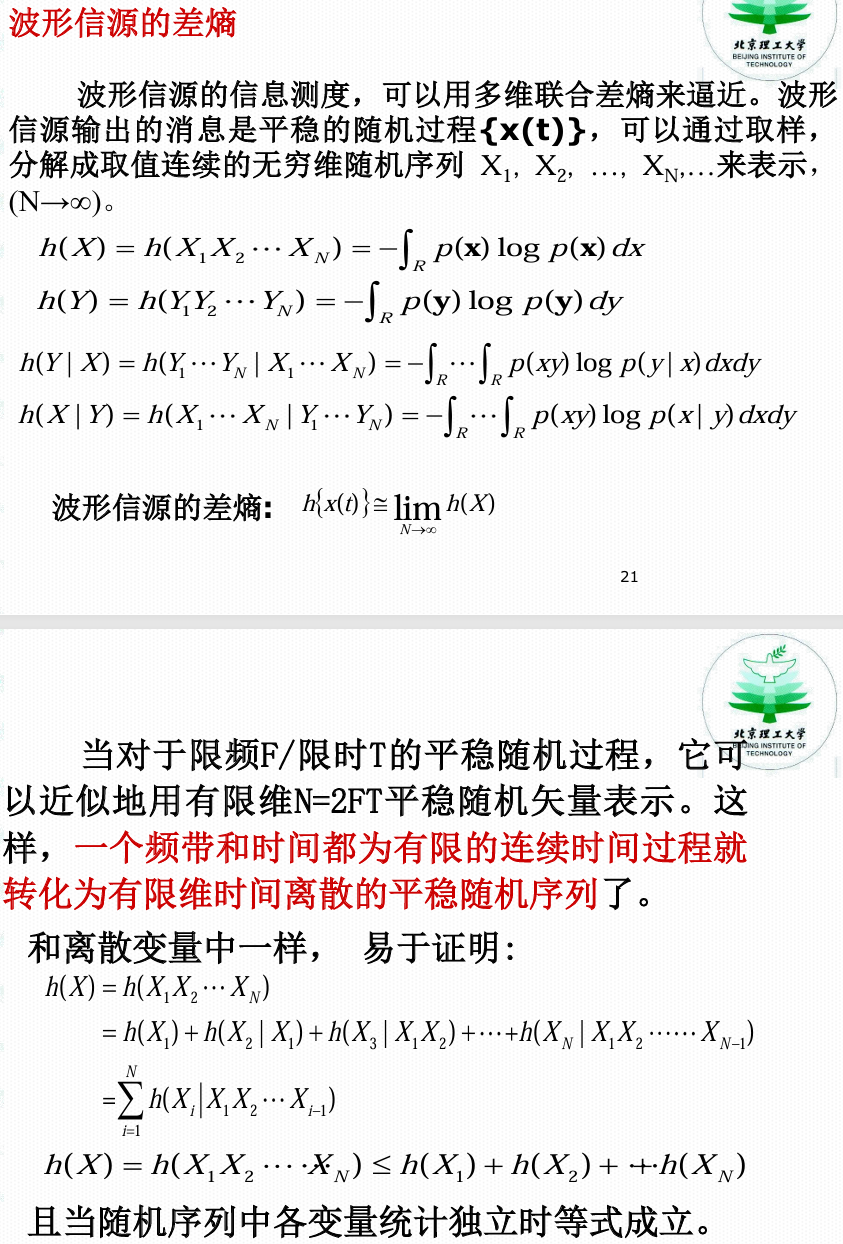

(4) 波形信源的差熵与熵率

- 对限频 F、限时 T 的随机过程 {x(t)},其取样形成 \(N=2FT\) 维随机向量:

\[ h(X_1, X_2, …, X_N) \]

熵率(单位时间信息量):

\[ h_t(X) = 2F \log_2(b-a)\ \text{比特/秒} \]

等一下,这个公式是不是只限定均匀分布?

第三节 连续信源熵的性质与最大差熵定理

1. 性质

可加性:

\(h(X,Y)=h(X)+h(Y|X)=h(Y)+h(X|Y)\)

凸性与极值性:

熵是 \(p(x)\) 的上凸函数。

可为负值:

因为是“相对熵”,不具备离散熵的非负性。

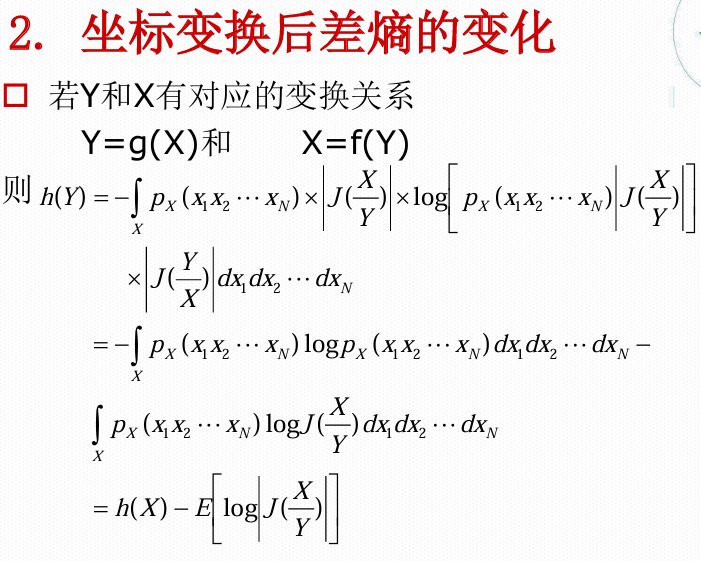

变换性:

若 \(Y=f(X)\) 是一一对应变换:

\[ h(Y)=h(X)+E[\log_2 |J(\frac{X}{Y})|] \]

其中 \(J\) 为雅可比行列式。

2. 最大差熵定理

(1)限峰值功率条件下:

若信源输出 \(X\in[a,b]\),则

当 \(p(x)\) 为均匀分布时,熵最大;

最大熵值:

\[ h_{\max} = \log_2(b-a) \]

(2)限平均功率条件下:

若 \(E[X^2]=P\) ,即输出信号的平均功率限定为P时,则

当 \(X\) 为高斯分布时,熵最大;

最大熵值:

\[ h_{\max} = \frac{1}{2}\log_2(2\pi e P) \]

说明:

均匀分布 ↔︎ 峰值受限

高斯分布 ↔︎ 平均功率受限

两者分别对应于两种常见的噪声:均匀噪声和高斯噪声。

这个和噪声是一个最不确定的随机过程,而最大的信息量只能从最不确定的事件中获得相一致的。

第四节 连续信源熵的变换

信源 \(X\) 经过线性变换 \(Y=kX+a\) 后:

对于概率密度函数:

\[p_Y(y_1 y_2 \cdots y_N) = p_X(x_1 x_2 \cdots x_N) \left| J\left( \frac{X}{Y} \right) \right|\]

对于差熵:

\[ h(Y)=h(X)+\log_2|k| \]

第五节 连续信道与波形信道分类

1. 定义

波形信道:输入、输出均为随机过程 \(\{x(t)\}\)、\(\{y(t)\}\);

连续信道:输入、输出为连续随机变量 \(X,Y\)。

经限时限频取样后:

\[ \{x(t)\} \to (X_1, X_2, …, X_N), \quad \{y(t)\} \to (Y_1, Y_2, …, Y_N) \]

从而波形信道可等效为多维连续信道。

2. 按统计特性分类

无记忆信道:输出仅与对应输入有关;

有记忆信道:输出与多时刻输入有关。

3. 按噪声类型分类

| 类型 | 描述 | 特点 |

|---|---|---|

| 高斯信道 | 噪声服从高斯分布 | 常用模型 |

| 白噪声信道 | 噪声功率谱密度恒定 | \(N_0/2\) |

| 有色噪声信道 | 功率谱密度随频率变化 | 有记忆 |

| 加性信道 | \(y=x+n\) | 噪声与信号独立 |

| 乘性信道 | \(y=x·n\) | 无线通信中常见 |

在加性信道中,条件熵:

\[ h(Y|X)=h(n) \]

称为噪声熵。

第六节 连续信道与波形信道的信息传输率

单符号连续信道

平均互信息:

\[ I(X;Y)=h(Y)-h(Y|X)=h(Y)-h(n) \]

多维连续信道

\[ I(X;Y)=\int\int p(x,y)\log_2\frac{p(x,y)}{p(x)p(y)}\,dxdy \]

平均每个自由度的信息传输率:

\[ R = \frac{1}{N}I(X;Y) \]

波形信道

单位时间信息传输率:

\[ R_t = \lim_{T\to\infty} \frac{1}{T} I(\{x(t)\}, \{y(t)\}) \]

平均互信息的性质

非负性:\(I(X;Y)\ge 0\)

对称性:\(I(X;Y)=I(Y;X)\)

上凸性:对输入分布上凸

信息不增性:数据处理定理

若 \(X \to Y \to Z\),则 \(I(X;Z)\le I(X;Y)\)

对应变换不变性:一一变换不改变 \(I(X;Y)\)

第七节 连续信道与波形信道的信道容量

信道容量定义为可实现的最大平均互信息:

\[ C = \max_{p(x)} I(X;Y) \]

一般连续信道:

\[ C = \max_{p(x)} [h(Y)-h(Y|X)] \]

加性连续信道:

噪声与输入独立,\(h(Y|X)=h(n)\),

\[ C = \max_{p(x)} [h(Y)-h(n)] \]

高斯加性信道(AWGN信道)

噪声 \(n\sim N(0,\sigma^2)\)

输入功率受限 \(E[X^2]=P\)

则输出 \(Y=X+n\)。

由最大熵定理,最优输入分布也是高斯。

输出熵:

\[ h(Y)=\frac{1}{2}\log_2(2\pi e (P+N)) \]

噪声熵:

\[ h(n)=\frac{1}{2}\log_2(2\pi e N) \]

容量:

\[ C = \frac{1}{2}\log_2\left(1+\frac{P}{N}\right)\quad \text{(比特/自由度)} \]

单位时间容量:

\[ C_t = F\log_2\left(1+\frac{P}{N}\right)\ \text{(比特/秒)} \]

这就是著名的香农信道容量公式,它指出:

在平均功率受限、加性高斯白噪声条件下,信息传输率存在上限。

第八节 香农公式的重要意义

揭示了带宽与信噪比对信息传输速率的基本限制;

为通信系统设计提供了理论极限;

说明提高通信速率的两条路径:

增大带宽;

提高信噪比;

是现代数字通信与编码理论的基础。